Inhaltsverzeichnis

- Moderne Datenmodellierung verstehen – der Grundstein jeder Datenstrategie

- Vom Konzept zur Struktur – Wie Datenmodellierung Unternehmen weiterbringt

- Datenmodellierungstechniken im Detail – Vom relationalen Modell bis zur objektorientierten Struktur

- Aufbau und Beziehung – So funktionieren moderne Datenmodelle in der Praxis

- Datenmodellierung im Alltag – Herausforderungen und Best Practices

- Datenmodellierung skalierbar gestalten – mit dem richtigen Tool zum Erfolg

- Welche Arten von Datenmodellierung gibt es?

- Organisation von Daten und Data Warehouse – warum Datenmodellierung strategisch wichtig ist

- Fazit: Datenmodellierung als Grundlage moderner Datenstrategien

- Häufige Fragen zur Datenmodellierung

Datenmodellierung im Zeitalter der Automatisierung – Warum jetzt der richtige Zeitpunkt ist

Datenmodellierung ist die Basis für jede datenbasierte Entscheidung in Unternehmen. Sie ist ein zentrales Element der digitalen Transformation und bestimmt, wie gut Daten genutzt, erweitert und analysiert werden können. Ob beim Aufbau von Software, der Organisation eines Data Warehouse oder bei KI-Projekten – ohne eine saubere Datenstruktur gibt es keine skalierbaren Lösungen.

1. Der Grundstein jeder Datenstrategie – moderne Datenmodellierung verstehen

Was ist Datenmodellierung?

Ein Datenmodell lässt sich mit einem Bauplan vergleichen.

Bevor ein Architekt ein Haus baut, erstellt er eine Zeichnung: Sie zeigt, wo die Wände stehen, wie die Räume verbunden sind und wo Strom und Wasser verlaufen. Genauso funktioniert ein Datenmodell: Es legt fest, welche Informationen gespeichert werden, wie sie zusammenhängen und wie man sie nutzen kann.

Datenmodellierung bedeutet also, echte Informationen in eine verständliche Struktur zu bringen. Dabei entstehen klare Modelle – oft in Form von Diagrammen oder Tabellen –, die zeigen, wie Informationen miteinander verknüpft sind. So lassen sich Daten einfacher speichern, abrufen und weiterverarbeiten.

Ein gutes Modell bildet die Grundlage für den gesamten Umgang mit Daten. Es macht komplexe Strukturen verständlich und überführt sie in standardisierte Formate. Typische Darstellungen sind etwa Entity-Relationship-Diagramme oder UML-Grafiken. Ziel ist es, eine logische Struktur zu schaffen, die für Fachabteilungen und Entwickler gleichermaßen verständlich ist.

Mit steigender Datenmenge wächst auch die Herausforderung, Ordnung zu schaffen. Begriffe wie relationale Datenmodellierung, hierarchische oder physische Modelle zeigen: Es gibt viele Wege, Daten sinnvoll zu strukturieren. Die Ursprünge dieser Ansätze reichen laut Wikipedia bis in die Anfänge der Informatik zurück – heute sind sie aktueller denn je.

Warum ist Datenmodellierung wichtig?

Ob bei einem neuen Data Warehouse, bei Business-Intelligence-Projekten oder wenn Daten aus verschiedenen Quellen zusammengeführt werden: Ein gut durchdachtes Datenmodell erhöht die Datenqualität, vermeidet doppelte Einträge und macht präzise Analysen möglich. Unternehmen, die ihre Daten sauber modellieren, treffen bessere Entscheidungen – schneller und nachhaltiger.

Ein gutes Modell zeigt frühzeitig Schwächen, lässt sich wiederverwenden und erleichtert die Zusammenarbeit zwischen Abteilungen. Besonders beim Wechsel auf neue Systeme oder bei Unternehmensfusionen zeigt sich der Wert klarer Datenstrukturen: Sie entscheiden oft darüber, ob ein Projekt erfolgreich ist oder scheitert.

KI trifft Datenmodellierung – Der Data Naicer von uNaice

Viele Unternehmen kämpfen mit chaotischen Datenquellen, unstrukturierten Informationen und hohem Pflegeaufwand. Der Data Naicer von uNaice löst genau dieses Problem: Er kombiniert feste Regeln mit künstlicher Intelligenz und erstellt automatisch strukturierte Produktdaten und Texte – auch bei großen, unübersichtlichen Datenmengen.

Anstatt viele einzelne Vorlagen manuell zu bauen, nutzt der Data Naicer ein flexibles System: Wenige Vorlagen reichen, um tausende Produkte automatisch zu beschreiben – exakt abgestimmt auf die vorhandene Datenstruktur. Die Integration erfolgt per API oder Webhook und lässt sich in Systeme wie ein Data Warehouse einbinden.

Ein Beispiel: Ein E-Commerce-Kunde konnte mit dem Data Naicer über 250.000 Produkttexte in 30 Sprachen generieren – automatisch, mit SEO-Optimierung und in markenspezifischem Stil. Was sonst Monate gedauert hätte, war in wenigen Wochen erledigt.

Auch Unternehmen wie IBM zeigen: Flexible Modellierungsansätze sind heute wichtiger denn je. Der Data Naicer bringt diese Flexibilität auf ein neues Level.

2. Vom Konzept zur Struktur – Wie Datenmodellierung Unternehmen weiterbringt

Datenmodelle im Arbeitsalltag: Wo sie wirklich helfen

Ein besonders wichtiger Einsatzbereich der Datenmodellierung ist die Datenintegration – also das Zusammenführen von Informationen aus verschiedenen Quellen. Gerade wenn ein Unternehmen viele unterschiedliche Systeme nutzt, hilft ein einheitliches Modell dabei, alle Daten verständlich und kompatibel aufzubereiten.

Ein durchdachtes Datenmodell ist nicht nur ein technischer Plan. Es ist die Grundlage für alle datenbasierten Prozesse im Unternehmen. Es zeigt, wie Informationen zusammenhängen, und sorgt für eine gemeinsame Sprache – egal ob in der IT, im Marketing oder in der Logistik.

Modellierungstechniken im Überblick: Vom logisch bis physisch

Welche Arten von Datenmodellen gibt es?

Es gibt drei grundlegende Typen der Datenmodellierung:

- Konzeptionelle Modelle: Diese beschreiben den groben Rahmen – also welche Datenarten es gibt und wie sie miteinander verknüpft sind.

- Logische Modelle: Sie bringen mehr Struktur ins Spiel. Hier geht es um Beziehungen, Schlüssel und Datentypen – unabhängig davon, in welchem System die Daten später landen.

- Physische Modelle: Sie legen fest, wie die Daten in der Praxis gespeichert werden – etwa in MySQL oder Oracle.

Ein guter Überblick über diese Modelltypen findet sich im Leitfaden zur Datenmodellierung von Salesforce.

Nicht nur für die IT: Datenmodellierung betrifft das ganze Unternehmen

Ein Datenmodell ist wie ein Stadtplan. Jede Abteilung – vom Vertrieb bis zur Buchhaltung – kann sich daran orientieren. Ohne ein gemeinsames Modell verliert man leicht den Überblick: Teams arbeiten aneinander vorbei, doppelte Daten entstehen und Entscheidungen basieren auf falschen Grundlagen.

Viele glauben, dass Datenmodellierung nur etwas für IT-Teams ist. Doch in Wahrheit hilft sie allen – vom Marketing über die Produktentwicklung bis zur Geschäftsführung. Ein sauberes Modell bringt Klarheit in die Daten, verbessert deren Qualität und macht sie überall nutzbar.

Praxisbeispiel: Wie KI bei der Datenmodellierung hilft

Ein Hersteller mit über 10.000 Produkten nutzte den Data Naicer von uNaice, um seine Datenmodellierung zu automatisieren. Die Herausforderung: unübersichtliche CSV-Dateien mit unterschiedlichen Attributen. Die Lösung: Ein flexibles Modell, das alle Produkte und deren Eigenschaften intelligent strukturiert. Das Ergebnis: 80 % weniger Aufwand bei der Textgenerierung – und eine deutlich bessere Datenqualität.

3. Datenmodellierungstechniken im Detail – Vom relationalen Modell bis zur objektorientierten Struktur

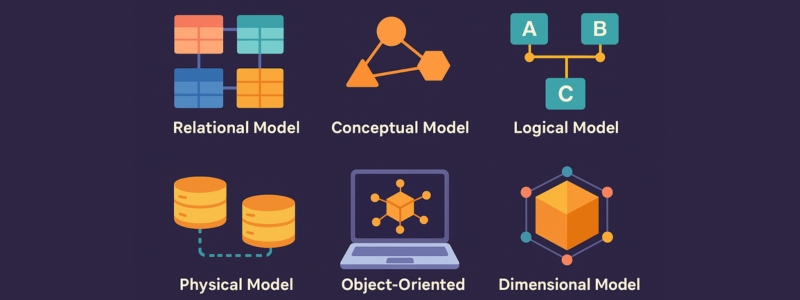

Überblick: Welche Modellierungsarten gibt es?

Je nach Anwendungsfall und Systemumgebung kommen unterschiedliche Datenmodellierungstechniken zum Einsatz. Besonders verbreitet ist das relationale Modell. Es strukturiert Daten in Tabellenform, wobei jede Tabelle eine Entität abbildet. Primär- und Fremdschlüssel sorgen für klare Verknüpfungen – ideal für strukturierte Daten mit festen Beziehungen.

Daneben gibt es drei weitere zentrale Modelltypen, die je nach Abstraktionsgrad unterschieden werden:

- Konzeptionelle Modelle: Zeigen auf hoher Ebene, welche Entitäten existieren und wie sie miteinander in Beziehung stehen – ohne technische Details.

- Logische Modelle: Detaillierter als das konzeptionelle Modell. Sie legen Datenstrukturen, Schlüssel, Attribute und Typen fest, unabhängig vom Datenbanksystem.

- Physische Modelle: Beschreiben die konkrete technische Umsetzung in einem System wie MySQL oder PostgreSQL, inkl. Speicherstruktur, Indexierung und Performance-Aspekten.

Ein anschaulicher Vergleich dieser Modelle findet sich im Artikel von Informatik Aktuell.

Ein Berliner Softwareunternehmen setzte genau diese drei Stufen in der Praxis um – von der ersten Skizze bis zum finalen Systemdesign. Mit Unterstützung des Data Naicer wurde das Projekt effizient umgesetzt. Das Ergebnis: 55 % kürzere Entwicklungszeit bei neuen Features. Einblick in datengetriebene Marketingprozesse gibt unser Beitrag zur Social Media Kampagne

Objektorientiert & dimensional – wann welche Technik passt

Für komplexe Anwendungen mit vielen Attributen bietet sich die objektorientierte Modellierung an. Sie stammt ursprünglich aus der Softwareentwicklung und ist besonders flexibel bei sich ändernden Anforderungen.

Dimensionale Modelle sind hingegen für Analysezwecke optimiert. Sie strukturieren Daten so, dass schnelle Auswertungen – etwa in einem Data Warehouse – möglich sind. Besonders bei großen Datenmengen bieten sie klare Vorteile für das Reporting.

Praxisbeispiel: Optimierung mit dimensionaler Modellierung

Ein E-Commerce-Unternehmen stellte von einem rein relationalen Modell auf eine kombinierte, dimensionale Struktur um – mit spürbarem Erfolg. Die Ladezeiten der Reports verbesserten sich um 70 %, der Wartungsaufwand sank deutlich.

4. Aufbau und Beziehung – So funktionieren moderne Datenmodelle in der Praxis

Mehr als nur Tabellen: So entsteht ein gutes Datenmodell

Ein Datenmodell ist der Bauplan für die Struktur eines Informationssystems. Es legt fest, wie Daten gespeichert, miteinander verknüpft und verarbeitet werden. Ein durchdachtes Modell spart nicht nur Speicherplatz, sondern erleichtert auch spätere Änderungen und Erweiterungen.

Wichtig ist dabei die Balance: Das Modell muss klar strukturiert und gleichzeitig praxisnah nutzbar sein – besonders bei großen Datenmengen. Visualisierungstools wie der Toad Data Modeler helfen, komplexe Beziehungen anschaulich darzustellen.

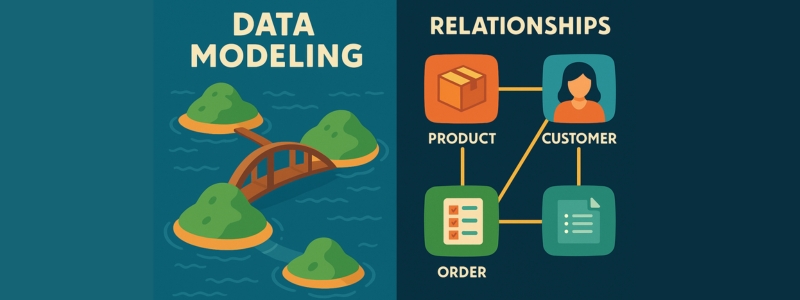

Ein einfaches Bild zur Veranschaulichung: Stell dir Entitäten als Inseln in einem See vor – die Beziehungen zwischen ihnen sind Brücken. Ohne diese Brücken bleiben die Dateninseln isoliert. Erst durch gut geplante Verbindungen entsteht ein nutzbares Netzwerk.

Beziehungen verstehen – das Herz jeder Modellierung

In relationalen Datenbanken sind sogenannte Relationships entscheidend. Sie definieren, wie Datensätze miteinander in Verbindung stehen – etwa 1:1, 1:N oder n:M.

Beispiel: Ein Unternehmen verwaltet Produkte, Kunden und Bestellungen. Ein Produkt kann in mehreren Bestellungen vorkommen. Ein Kunde kann viele Bestellungen auslösen. Nur wenn diese Beziehungen sauber modelliert sind, bleiben Daten konsistent und auswertbar.

Dokumentationstools sorgen dafür, dass diese Strukturen dauerhaft verständlich bleiben – auch bei künftigen Anpassungen.

Modellierung in MySQL & Co.

Die Umsetzung erfolgt in Systemen wie MySQL, PostgreSQL oder Oracle. Diese Datenbanken bieten Funktionen zur automatischen Prüfung von Datentypen, Schlüsseln und Abhängigkeiten – besonders wichtig bei großen Datenmengen.

Ein gutes Modell beschleunigt Abfragen, reduziert Fehler und macht Systeme insgesamt leistungsfähiger.

Praxisbeispiel: Skalierung mit sauberer Struktur

Ein mittelständisches E-Commerce-Unternehmen musste seine MySQL-Datenbank optimieren. Die Ausgangslage: unklare Beziehungstypen und doppelte Informationen.

Lösung: Zunächst wurde das bestehende Modell per Reverse Engineering analysiert, dann mithilfe objektorientierter Modellierung neu aufgebaut. Das Ergebnis: 60 % mehr Performance – und 40 % weniger Fehler beim Checkout.

5. Datenmodellierung im Alltag – Herausforderungen und Best Practices

Zwischen Theorie und Praxis: Wo Unternehmen scheitern

Trotz klarer Konzepte zur Datenmodellierung haben viele Unternehmen Schwierigkeiten bei der Umsetzung. Laut einer Umfrage von Gartner (2023) erreichen nur etwa 30 % der Unternehmen eine konsistente Datenqualität in ihren Datenmodellen. Häufige Gründe sind fehlende prozessorientierte Strukturen, unklare Datenquellen oder mangelhafte Dokumentation.

Der Faktor Beziehung: Warum „Relationship“ das Herz der Modellierung ist

In der Praxis ist die saubere Definition von Beziehungen entscheidend für die Funktionalität eines Datenmodells. Falsch definierte Beziehungen führen zu Redundanzen, Datenverlusten oder ineffizienten Abfragen. Besonders bei relationalen Datenbanken ist dies kritisch – fehlerhafte Beziehungen sind hier oft die Hauptursache für spätere Systemprobleme.

Fallbeispiel: Wie ein Hersteller seine Datenarchitektur mithilfe von KI optimierte

Ein mittelständischer Möbelhersteller aus Deutschland stand vor der Herausforderung, über 15.000 Produktdatensätze in ein neues PIM-System zu überführen. Mit dem Data Naicer von uNaice konnten unstrukturierte CSV-Dateien in ein standardisiertes Datenmodell überführt werden – inklusive automatisierter Schlüsselerkennung, Relationship-Definition und Dokumentation. Das Ergebnis: Eine um 40 % verkürzte Time-to-Market, verbesserte Datenverwaltung und eine deutlich höhere Datenqualität.

Best Practices für nachhaltige Datenmodellierung

- Frühzeitig modellieren – nicht erst, wenn Systeme bereits implementiert sind.

- Datenquellen klären und strukturieren, bevor mit der Modellierung begonnen wird.

- Werkzeuge nutzen, die Datenmodellierung auch bei großen Datenmengen ermöglichen – wie der Data Naicer.

- Dokumentation nicht vernachlässigen – sie ist ein zentraler Bestandteil jeder erfolgreichen Datenstrategie.

- Fortlaufend prüfen und anpassen, denn Datenmodellierung ist ein kontinuierlicher Prozess.

Dieses überarbeitete Kapitel verwendet eine klarere Sprache und integriert die gewünschten SEO-Schlüsselwörter, um sowohl die Lesbarkeit zu verbessern als auch die Sichtbarkeit in Suchmaschinen zu erhöhen. Wenn du weitere Anpassungen oder zusätzliche Kapitel benötigst, stehe ich gerne zur Verfügung.

6. Datenmodellierung skalierbar gestalten – mit dem richtigen Tool zum Erfolg

Wenn Datenmodelle an ihre Grenzen stoßen

Datenmodellierung erscheint auf dem Papier oft klar und logisch – doch in der Praxis stoßen viele Unternehmen schnell an ihre Grenzen. Unstrukturierte Datenmengen, inkonsistente Formate und manuelle Pflegeprozesse führen zu Verzögerungen und Qualitätsproblemen. Spätestens wenn tausende Produkte, mehrere Märkte und unterschiedliche Datenquellen zusammengeführt werden sollen, wird deutlich: Skalierbarkeit ist der Schlüssel. Besonders bei tausenden oder gar Millionen Produkten, die jeweils über zig Attribute verfügen, stoßen klassische Tools oder manuelle Modellierungsprozesse schnell an ihre Grenzen. Die Struktur, Darstellung und Verarbeitung solcher Datenmengen wird zur Herausforderung – vor allem, wenn es um Konsistenz, Verständnis und Wiederverwendbarkeit geht.

Die Antwort auf große Datenmengen: der Data Naicer

Genau hier setzt der Data Naicer von uNaice an. Die SaaS-Lösung kombiniert regelbasierte Modellierungslogiken mit Künstlicher Intelligenz und verarbeitet sowohl strukturierte als auch unstrukturierte Daten automatisiert in modellierbare Formate. Das spart nicht nur enorm viel Zeit, sondern erhöht die Datenqualität signifikant.

Was macht den Unterschied?

- Templates mit hoher Flexibilität: Im Gegensatz zu traditionellen Templates, die oft nur bei bestimmten Datensätzen funktionieren, deckt der Data Naicer eine breite Variabilität von Attributen ab – bei gleichzeitig klarer Darstellung.

- Kombination aus Regelwerk & KI: Wo die klassische Regel nicht mehr ausreicht, greift die KI ein – etwa bei uneinheitlicher Benennung oder fehlenden Werten.

- Projektspezifischer Aufbau: Jede Lösung wird individuell entworfen, orientiert an den Anforderungen des Unternehmens.

Fallbeispiel: Vom CSV-Chaos zur strukturierten Datenarchitektur

Ein Hersteller mit über 50.000 Produkten hatte seine Datensätze nur als lose CSV-Dateien ohne definierte Schlüssel oder Relationships. Durch den Einsatz des Data Naicer wurde ein konsistentes Datenmodell aufgebaut – inklusive konzeptioneller Struktur, Dokumentation und automatisierter Verwaltung. Ergebnis: Automatisierte Textgenerierung für alle Produktseiten in vier Sprachen – und das in weniger als drei Wochen.

Auch für kleinere Teams: Kein Expertenwissen nötig

Ein weiterer Vorteil: Der Data Naicer ist kein klassisches Entwickler-Tool. Er wurde so konzipiert, dass auch nicht-technische Teams damit arbeiten können. Die Oberfläche ist intuitiv, die Bedienung einfach – und wer mag, lässt sich von uNaice im Managed Service begleiten. Damit ist datenmodellierung nicht länger ein Bottleneck, sondern ein echter Wachstumstreiber.

7. Welche Arten von Datenmodellierung gibt es?

Vielfalt in der Modellierung: Von klassisch bis KI-gestützt

Die Datenmodellierung lässt sich in verschiedene Typen unterteilen, abhängig vom Abstraktionsgrad und der Zielsetzung. Klassischerweise unterscheidet man zwischen:

- Konzeptionelle Datenmodelle: Sie dienen dem groben Überblick – z. B. welche entitäten es gibt und in welcher beziehung sie stehen.

- Logische Datenmodelle: Diese beschreiben die Struktur der Daten unabhängig vom Datenbanksystem. Es geht um Schlüssel, Normalisierung und Datentypen.

- Physische Datenmodelle: Sie zeigen, wie die Daten tatsächlich in einem konkreten System gespeichert werden – inkl. Indexierung, Partitionierung und Performance-Aspekten.

Daneben gibt es objektorientierte Datenmodelle, relationale Datenmodellierung, dimensionale Modelle für OLAP-Analysen und hybride Ansätze, bei denen verschiedene Strukturen kombiniert werden.

Für viele Unternehmen sind auch kostenlose Datenmodellierungstools ein Einstieg – diese bieten oft grafische Oberflächen, einfache Notation und helfen beim ersten Verständnis.

Falls du dich für den Einsatz von KI im Textbereich interessiert: In unserem Blogartikel zum KI Textgenerator im Test zeigen wir, wie automatisierte Inhalte heute schon performen können – auch in komplexen datengetriebenen Umfeldern.

Wie entwickelt sich die Datenmodellierung weiter?

Die Datenmodellierung steht aktuell vor einem Paradigmenwechsel: Weg von starren Tabellen – hin zu flexiblen, semantischen Modellen, die sich automatisch an Daten ändern können. Techniken wie Reverse Engineering, KI-basierte Modellanpassung und dynamische Templates (wie im Data Naicer) setzen neue Standards.

Ein zukunftsweisender Aspekt: die datenarchitektur als Service. Unternehmen wollen keine Tools mehr kaufen – sie wollen Lösungen, die ihre datenprobleme lösen. Genau das bietet uNaice mit dem Data Naicer als Managed Service.

8. Organisation von Daten und Data Warehouse – warum Datenmodellierung strategisch wichtig ist

Datenmodellierung ist nicht nur ein technisches Werkzeug – sie ist ein strategischer Hebel. Wer heute klug modelliert, schafft morgen die Basis für flexible Datenarchitekturen, schnellere Entscheidungsprozesse und zukunftssichere Skalierbarkeit. In einer gut strukturierten Organisation ist sie der Schlüssel zur effizienten Nutzung und langfristigen Speicherung großer Datenmengen.

Wie Datenmodellierung die Organisation langfristig verbessert

Ein durchdachtes logisches Modell bildet die Grundlage für die spätere physische Umsetzung in Systemen wie einem Daten Warehouse. Besonders bei wachsendem Datenvolumen kommt es darauf an, dass die maximale Anzahl an Informationen nicht nur gespeichert, sondern auch nutzbar gemacht wird – für Analysen, Reporting und operative Prozesse.

Die Verwendung standardisierter Modellierungstechniken schafft nicht nur Effizienz, sondern reduziert auch die Fehleranfälligkeit. Eine klare Definition von Beziehungen, Datentypen und Geschäftslogik im Modell verhindert spätere Redundanzen und Dateninkonsistenzen.

Ein oft unterschätzter Aspekt ist die Abstraktion: Nur wer in der Lage ist, komplexe Sachverhalte in einfache Strukturen zu übersetzen, kann diese langfristig pflegen und weiterentwickeln. Genau hier setzt der methodische Ansatz an – von der Betrachtung der Fachanforderungen bis zur finalen Umsetzung und Entwerfen passender Modelle.

Regelbasierte Verfahren – also die Anwendung vordefinierter Regeln für bestimmte Datenmuster – spielen dabei eine entscheidende Rolle. Sie helfen, eine klare Datenstruktur zu schaffen, die sowohl skalierbar als auch wartbar ist.

Ein Beispiel: Ein Unternehmen, das international tätig ist, benötigt ein Data Warehouse, das sowohl lokale als auch globale Anforderungen berücksichtigt. Hierzu ist eine Modellierung notwendig, die verschiedene Quellen, Sprachen und Geschäftsprozesse harmonisiert – und genau dafür bietet unser Data Naicer das ideale Fundament.

9. Fazit: Datenmodellierung als Grundlage moderner Datenstrategien

Die Datenmodellierung ist weit mehr als ein technischer Schritt in der Datenverarbeitung – sie spielt eine wichtige Rolle als strategische Disziplin, die über die Definition, Struktur und den Erfolg ganzer Datenlandschaften entscheidet. Wer seine Daten zielgerichtet modelliert, schafft klare Prozesse, bessere Analysen und eine Grundlage für fundierte Geschäftsentscheidungen.

Ein durchdachtes Datenmodell folgt klar definierten Regeln – von der Abstraktion über die Verbindung von Entitäten bis zur Gewährleistung logischer Konsistenz. Gleichzeitig bleibt die Datenmodellierung ein dynamisches Feld, das sich mit Technologien wie KI, automatisierten Tools und neuen Ansätzen wie dem Data Naicer laufend weiterentwickelt.

Gerade für Unternehmen, die viele Daten aus unterschiedlichen Quellen integrieren wollen, ist es entscheidend, frühzeitig ein skalierbares Modell aufzusetzen – und damit eine nachhaltige Datenarchitektur zu schaffen. Wer heute mit den richtigen Tools arbeitet, spart morgen nicht nur Ressourcen, sondern sichert sich langfristige Wettbewerbsvorteile.

🚀 Verabschiede dich vom Datenchaos!Mit dem Data Naicer modellierst du große Datenmengen automatisiert, effizient und passgenau.👉 Jetzt mehr erfahren und kostenlose Beratung sichern

Häufige Fragen zur Datenmodellierung

Was unterscheidet relationale und hierarchische Datenmodelle?

Relationale Datenmodelle speichern Informationen in Tabellen, die über Schlüssel miteinander verknüpft sind. Hierarchische Datenmodelle hingegen organisieren Daten in einer baumartigen Struktur – ähnlich einem Stammbaum. Beide Ansätze haben ihre Stärken je nach Datenart und Anwendungsfall.

Wie unterstützt ein gutes Datenmodell fundierte Entscheidungen?

Ein durchdachtes Datenmodell sorgt für eine klare Darstellung und Struktur der Informationen. Das erleichtert Analysen und verbessert die Datenqualität – eine wichtige Basis für fundierte Entscheidungen in allen Unternehmensbereichen.

Welche Tools helfen bei der Erstellung von Datenmodellen?

Zur einfachen Erstellung eignen sich Tools wie Oracle SQL Developer Data Modeler. Sie unterstützen bei der Visualisierung, Bearbeitung und Pflege der Modelle – auch bei komplexen Datenbanken.

Was ist der Unterschied zwischen logischer und physischer Datenmodellierung?

Die logische Datenmodellierung beschreibt die Struktur der Daten unabhängig von einem konkreten System. Die physische Datenmodellierung hingegen definiert, wie die Daten tatsächlich in einer Datenbank gespeichert werden – inklusive technischer Details wie Partitionierung und Indexierung.

Wann ist der Einsatz von dimensionaler Datenmodellierung sinnvoll?

Dimensionales Modellieren eignet sich besonders für Analyse- und Reportingzwecke – etwa im Data Warehouse. Hier können große Datenmengen effizient ausgewertet werden.

Wie funktioniert die Entwicklung objektorientierter Datenmodelle?

Bei der Entwicklung objektorientierter Datenmodelle orientiert man sich an Konzepten der Softwareentwicklung. Daten werden als Objekte mit Eigenschaften und Methoden modelliert – ideal für komplexe Anwendungen mit dynamischen Strukturen.