KI-Sprachmodelle und der Textroboter

Warum der letzte Spross der GPT-Familie keine Revolution in der Content Automation ist und wann der Textroboter besser ist

Gestatten, ChatGPT mein Name

GPT-4: A star is born?

Ja, das KI-Sprachmodell GPT-4 ist erschienen! Und wieder ist das gesamte Netz in hellster Aufregung. Wie es scheint, hat der neue multimodale Sprössling von OpenAI seine Fähigkeiten im kreativen Schreiben weiter ausgebaut und ist nun auch in der Lage, längere Zusammenhänge und visuelle Elemente besser zu verstehen. Vorerst wird GPT-4 nur im Bezahlmodus GPT-4 Plus und als API für Entwickler zum Bauen eigener Anwendungen verfügbar sein, wobei für den API-Zugriff eine Warteliste besteht. Wegen dieses schrittweisen Rollouts werden wir in diesem Beitrag deshalb trotzdem die Fähigkeiten von ChatGPT unter die Lupe nehmen.

GPT-4 vs ChatGPT

GPT-4 unterscheide sich laut OpenAI-CEO Sam Altman in seiner Konversationsfähigkeit nur sehr geringfügig von GPT-3.5 (eine verbesserte Version vonGPT-3), welches das KI-Modell hinter ChatGPT ist, und den meisten Nutzern bereits bekannt sein dürfte. Die Architektur dürfte also nicht bahnbrechend verändert worden sein, und das Modell wird wohl weiterhin ein humanoides, aber noch lange kein menschengleiches neuronales Netzwerk aufweisen.

Das Sprachverarbeitungsmodell ChatGPT steht an der Spitze der GPT-3-Modelle und wurde vom No-Profit-Unternehmen OpenAI hergestellt. Seit seiner Lancierung macht es On- und Offline regelrecht Furore. Es erstellt Texte, kann diese zusammenfassen, übersetzen oder vereinfachen und benutzt dazu das Verfahren des Deep Learnings. In diesem Beitrag werden wir aufzeigen, inwiefern diese KI ein wahrhaftes Sprachgenie ist, und weshalb es dennoch nicht für alle Use Cases das richtige Tool zur Content Automation ist. Im ersten Teil beschreiben wir die Entstehungsgeschichte des Sprachmodells und wie es so tickt. In den beiden darauf folgenden Beiträgen werden wir auf seine konkreten Fähigkeiten eingehen und es dem Härtetest anhand von verschiedenen Use Cases unterziehen. Wer wird besser abschneiden, ChatGPT oder unser Textroboter?

OpenAI

Die Non-Profit-Organisation OpenAI wurde im Jahr 2015 von Elon Musk, Sam Altman und anderen Investoren in San Francisco ins Leben gerufen. Das ambitionierte Team von OpenAI versteht sich als Blue-Sky-Forschungslabor zu den Möglichkeiten der künstlichen Intelligenz und macht die Ergebnisse der Öffentlichkeit zugänglich. Erklärtes Ziel von OpenAI ist die Erschaffung einer zunehmend leistungsfähigen, menschenähnlichen Intelligenz, die in der Lage ist, immer mehr Aufgaben zu übernehmen. Interessenskonflikte mit anderen Unternehmen haben Elon Musk Anfang 2018 dazu bewogen, OpenAI nicht mehr auf Verwaltungsebene mitzuführen, sondern als stiller Geldgeber aus dem Hintergrund zu agieren.

Neben GPT-1, GPT-2, GPT-3 und GPT-4 hat OpenAI über die Jahre mehrere KI-Produkte hergestellt. Darunter gehören unter anderem:

OpenAI Gym

OpenAI Gym ist ein Toolkit für die Entwicklung und den Vergleich von Reinforcement Learning Algorithmen

OpenAI Universe

OpenAI Universe ist eine Softwareplattform zum Messen und Trainieren der allgemeinen Intelligenz einer KI im weltweiten Angebot von Spielen, Websites und anderen Anwendungen

OpenAI Five

OpenAI Five ist ein System, dass das Videospiel Dota 2 gegen sich selbst spielt

Die GPT-Familie

Generative pre-trained Transformer (GPT) ist eine Familie von Sprachmodellen, die im Allgemeinen auf einem großen Korpus von Textdaten trainiert werden, um menschenähnlichen Text zu erzeugen. Sie können alle für verschiedene Aufgaben der Verarbeitung natürlicher Sprache wie Texterzeugung, Sprachübersetzung und Textklassifizierung feingetunt werden. Das „Vortraining“ im Namen bezieht sich auf den anfänglichen Trainingsprozess auf einem großen Textkorpus, bei dem das Modell lernt, das nächste Wort in einer Passage vorherzusagen. Dies schafft eine solide Grundlage für das Modell, um bei Downstream-Aufgaben mit begrenzten Mengen an aufgabenspezifischen Daten gute Leistungen zu erbringen.

Die Einführung des Sprachmodells hat die Welt der Künstlichen Intelligenz definitiv in eine neue Ära geführt, da es sich bei diesem Sprachtransformator um ein maschinelles Lernsystem handelt, dessen Algorithmus nicht für eine spezifische Aufgabe geschult wird. Vielmehr basiert die Verarbeitung natürlicher Sprache (NLG) auf einer mehrwertigen Deep-Learning-Architektur, die neuronale Netze bildet und auch darin den Menschen imitiert.

GPT-1

2018 entwickelte OpenAI ein allgemeines, Aufgaben-übergreifendes Modell (GPT-1), dessen generatives Vortraining anhand eines Book Corpus durchgeführt wurde. Das Modell verwendete unüberwachtes und halbüberwachtes Lernen. Die ursprüngliche GPT-Studie zeigte, wie ein generatives Sprachmodell in der Lage ist, Wissen über die Welt zu erwerben und weitreichende Abhängigkeiten zu verarbeiten. Bei diesem Grundmodell erfolgte das Vortraining mit Hilfe von unlabeled Data, um das Modell anschließend anhand von Beispielen für bestimmte nachgelagerte Aufgaben wie Klassifizierung, Stimmungsanalyse, Textbedingungen usw. zu optimieren. Unüberwachtes Lernen diente als Vortrainingsziel für überwachte, fein abgestimmte Modelle, daher der Name Generatives Vortraining. Mehr zum Thema “Lernmethoden”.

Das halbüberwachte Lernen (unüberwachtes Vortraining, gefolgt von überwachter Feinabstimmung) für NLP-Aufgaben beinhaltet die folgenden drei Komponenten:

- Unüberwachte Sprachmodellierung („Vortraining“): Für das unüberwachte Lernen wurde ein Standard-Sprachmodell verwendet.

- Überwachtes Fine-Tuning: Dieser Teil zielt darauf ab, die Wahrscheinlichkeit eines bestimmten Labels bei gegebenen Merkmalen oder Token zu maximieren.

- Aufgabenspezifische Eingabeumwandlungen: Um die Architektur des Modells während der Feinabstimmung möglichst wenig zu verändern, wurden die Eingaben für die spezifischen nachgeordneten Aufgaben in geordnete Sequenzen umgewandelt.

GPT-1 schnitt in 9 von 12 verglichenen Aufgaben besser ab als speziell trainierte, überwachte Spitzenmodelle. Eine weitere wichtige Errungenschaft dieses Modells war seine Fähigkeit, im Test zu erkennen, was es während des Trainings noch nicht gesehen hatte (Zero-Shot-Learning).

Die Architektur von GPT-1 erleichterte das Transferlernen und konnte verschiedene NLP-Aufgaben mit sehr wenig Feinabstimmung durchführen. Dieses Modell zeigte die Leistungsfähigkeit des generativen Pre-Trainings und eröffnete Wege für die folgenden Modelle, die dieses Potenzial mit größeren Datensätzen und mehr Parametern weiter ausschöpfen.

GPT-2

Daraufhin wurde das GPT-1-Modell von OpenAI weiterentwickelt, bis 2019 GPT-2 veröffentlicht wurde, wobei die Vollversion aus Sorge vor möglichem Missbrauch (Anwendungen zum Schreiben von Fake News etc.) nicht sofort freigegeben wurde.

Einige Expert:innen waren sehr skeptisch und befürchteten, GPT-2 könne eine signifikante Bedrohung darstellen. Sie warnten vor dieser Technologie, die das Web vollständig mit vernünftig klingenden, kontextgerechten Texten überfüllen würde, die jede andere Textform überdecken würden und unmöglich zu filtern wären. Bei GPT-2 handelt es sich um ein unüberwachtes Sprachmodell und damit um einen Allgemeinen-Lerner. Der WebText-Corpus (zuzüglich der Reddit-Platform), an dem es trainiert wurde, enthält über 8 Millionen Dokumente mit insgesamt 40 Gigabyte Text aus den URLs.

Die wichtigste Änderung bestand darin, einen größeren Datensatz zu verwenden und dem Modell mehr Parameter hinzuzufügen, um ein noch stärkeres Sprachmodell zu generieren. Es wurde also ein signifikant größerer Datensatz mit mehr Parametern verwendet, um ein mächtigeres Sprachmodell zu schaffen (1,5 Milliarden Parameter und damit 10 Mal mehr als GPT-1 mit seinen 117 Millionen Parametern). Das Ergebnis war, dass GPT-2 eine bessere Leistung erbrachte, da es einfach mehr Daten hatte, an denen es sich die Muskeln stählen und trainieren konnte. So konnten sich an die bereits vorhandenen Fähigkeiten des Vorgängers GPT-1 weitere Skills reihen, und tatsächlich schnitt das Modell bei jeder nachgelagerten Aufgabe (wie Leseverständnis, Zusammenfassungen, Übersetzungen, Beantwortung von Fragen usw.) besser ab als GPT-1. Gleichzeitig reduzierte es die Fehlerhäufigkeit von 99,8 auf 8,6 und verbesserte die Genauigkeit erheblich.

GPT-2 hat gezeigt, dass das Training an größeren Datensätzen und mit mehr Parametern die Fähigkeit des Sprachmodells, Aufgaben zu verstehen, um ein Wesentliches verbessert. Somit war der Grundstein für GPT-3 und ChatGPT gelegt.

GPT-3

In seinem Bestreben, sehr starke und leistungsfähige Sprachmodelle zu entwickeln, die keine Feinabstimmung und nur wenige Anleitungen benötigen, um Aufgaben zu verstehen und auszuführen, entwickelte OpenAI das GPT-3-Modell mit 175 Milliarden Parametern. Es wurde im Jahr 2020 veröffentlicht und hat 100 Mal mehr Parameter als GPT-2. Aufgrund der großen Anzahl von Parametern und des umfangreichen Datensatzes, auf dem GPT-3 trainiert wurde, erbringt es extrem gute Leistungen bei nachgelagerten NLP-Aufgaben.

Dank seiner großen Kapazität kann GPT-3 Artikel schreiben, die schwer von denen zu unterscheiden sind, die von Menschen geschrieben wurden. Er kann auch spontan Aufgaben ausführen, für die es nie explizit trainiert wurde, wie das Zusammenzählen von Zahlen, das Schreiben von SQL-Abfragen und -Codes, das Entschlüsseln von Wörtern in einem Satz, das Schreiben von React- und JavaScript-Codes anhand einer natürlichsprachlichen Aufgabenbeschreibung usw. Bereits im September 2020 erhielt Microsoft eine Exklusiv-Lizenz für GPT-3.

|

⬇️ GPT Neo |

⬇️ GPT Babbage |

⬇️ GPT Curie |

⬇️ GPT DaVinci |

⬇️ ChatGPT |

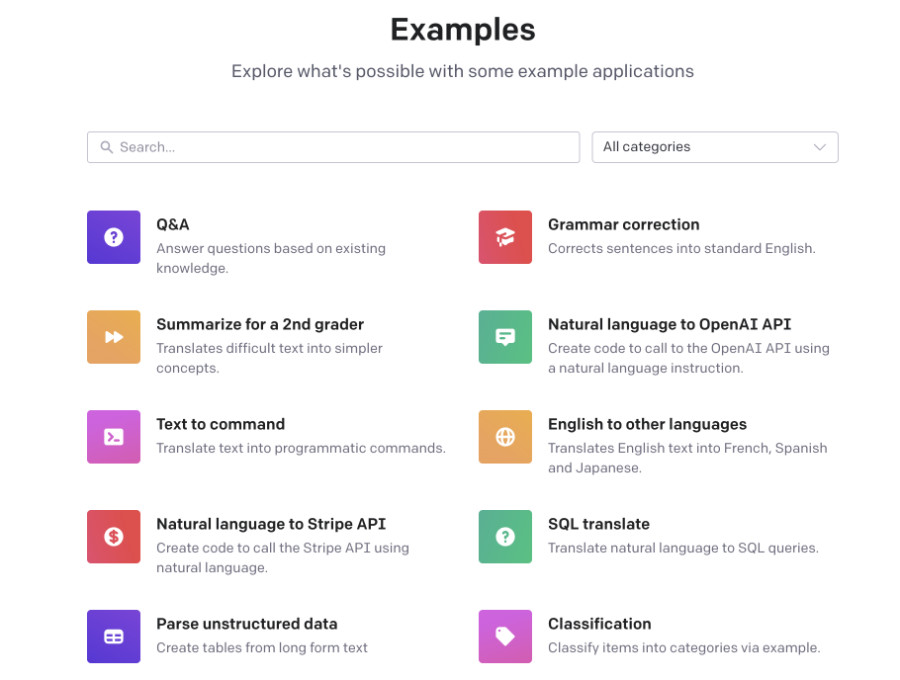

Im Grunde unterscheiden sich alle diese Modelle in ihrer Größe. Je größer die Dimensionen und je mehr Parameter sie handhaben können, desto mehr Aufgaben können sie erfüllen und desto mehr Skills haben sie, wie zum Beispiel:

Q&A

Beantworten von Fragen auf der Grundlage des vorhandenen Wissens.

| Korrektur der Grammatik | Zusammen-fassungen | Übersetzt Englisch in andere Sprachen | Befehltexte | Chats mit Freunden |

| Korrigiert Sätze in Standard-Englisch. | Übersetzt schwierige Texte in einfachere Konzepte. | Übersetzt englischen Text ins Französische, Spanische und Japanische… | Übersetzt Text in program-matische Befehle. | Simuliert SMS-Gespräche. |

und so weiter…

ChatGPT ist die Spitze der GPT-3-Familie. Es handelt sich dabei um einen Chatbot, der im November 2022 auf den Markt kam. Nach Eingabe eines Prompt-Textes wird er einen Text produzieren, der die Aufforderung fortsetzt. Er wurde mit verschiedenen Lernmethoden verfeinert und verstärkt.

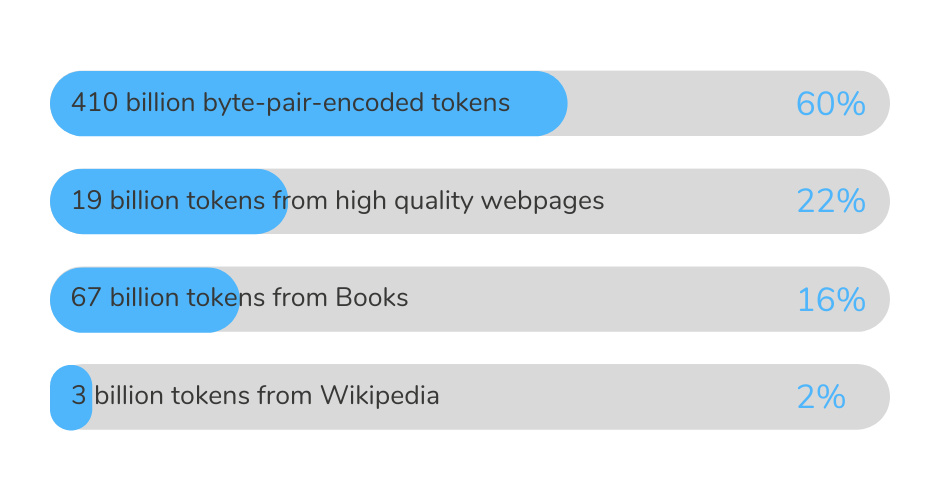

ChatGPT wurde mit einem riesigen und vielfältigen Textkorpus sowie mit Hunderten von Milliarden von Wörtern vortrainiert:

GPT-3 wird mit einer Kombination aus überwachtem und unüberwachtem Lernen trainiert, um das nächste Token auf der Grundlage der vorherigen Token vorherzusagen.

Mit ChatGPT befinden wir uns also bereits in der 3. Generation von GPT-Modellen. Das bedeutet, dass ChatGPT nicht wirklich eine Revolution in der Textautomatisierung darstellt. Für das Jahr 2023 ist die Einführung von GPT-4 vorgesehen — ein Modell, das sicher noch eine Vielzahl weiterer Fähigkeiten aufweisen wird.

GPT-4

GPT-4 wurde mit 100 Billionen Parametern trainiert, im Vergleich zu 175 Milliarden Parametern bei GPT-3, was es ihm ermöglicht, komplexere Aufgaben mit höherer Genauigkeit und einem verbesserten Alignment zu lösen.

Alignment ist eine verbesserte Abstimmung zwischen User-Prompt:innen und Textoutput.

Dadurch kann GPT-4 natürlich eine Vielzahl von weiteren Anwendungen abdecken. Vor allem ist das Sprachmodell durch das Training mit einer so enormen Datenmenge in der Lage, die natürliche Sprache besser zu imitieren. Allerdings will sich OpenAI laut eigenen Aussagen eher darauf konzentrieren, die GPT-Modelle zu optimieren, anstatt sie unbegrenzt zu vergrößern und zu erweitern. Klar ist, dass GPT-4 wahrscheinlich noch menschenähnlicher arbeiten wird als jedes andere vorangegangene GPT-Modell.

Die Textausgabe ist bei GPT-4 außerdem nicht skalierbar. Auch wird das Modell trotz der vielen Verbesserungen weiter „halluzinieren“. Obwohl es über viele Fähigkeiten verfügt, hat GPT-4 also die gleichen Einschränkungen wie seine Vorgänger. Es ist nicht vollständig zuverlässig, es erfindet Fakten und begeht Denkfehler.

Der wichtigste Unterschied zu vorangegangenen Modellen ist wohl die Möglichkeit, Bilder als Input zu verarbeiten. Dahingehend wurde auch sein Deep Learning ausgerichtet. So kannst du etwa ein Foto, eine Grafik oder ein Screenshot prompten und GPT-4 kann daraus erkennen und in Worten beschreiben, was auf dem Foto ist.

Wie auch bereits bei GPT-3 gibt es allerdings Begrenzungen, denn auch GPT-4 wurde nur mit Daten bis zum Jahr 2021 gefüttert – sprich seine Weltkenntnis endet im September 2021. Was danach passiert ist, gehört nicht zu seinem Universum und wird daher auch nicht in den Outputs berücksichtigt werden.

Lernmethoden

Wie wir vorab bereits erfahren haben, benutzen die verschiedenen GPT-Modelle unterschiedliche Lernmethoden. Hier folgt eine kurze Beschreibung:

Überwachtes maschinelles Lernen

Beim überwachten maschinellen Lernen sind alle Daten im Datensatz gelabelt, und die Algorithmen lernen, die Ausgabe anhand der Eingabedaten vorherzusagen.

Gelabelte Daten sind gemeinhin Daten, für die ein Vorverständnis der Funktionsweise der Welt besteht. Ein menschlicher oder automatischer Tagger muss sein Vorwissen nutzen, um die Daten mit zusätzlichen Informationen zu versehen. Typische Beispiele für gelabelte Daten sind: Ein Bild einer Katze oder eines Hundes, mit einem zugehörigen Label „Katze“ oder „Hund“.

Unüberwachtes maschinelles Lernen

Beim unüberwachten maschinellen Lernen sind alle Daten im Datensatz ungelabelt. In diesem Fall lernen die Algorithmen aus den Eingabedaten eine innewohnende Struktur zu erkennen.

Was sind ungelabelte Daten? Das sind Daten in ihrer Reinform. Wenn wir einen Schalter betätigen oder unsere Augen öffnen und nichts über unsere Umgebung oder die Funktionsweise der Welt wissen, sammeln wir ungelabelte Daten. Wir müssen auch nichts darüber wissen, wie diese Welt funktioniert.

In Verbindung mit ungelabelten Daten herrscht nur sehr wenig oder gar kein Vorwissen.

Teilüberwachtes Lernen

Bei dieser Lernmethode sind einige der Daten des Datensatzes gelabelt, aber die meisten von ihnen sind in der Regel nicht gelabelt. Es ergibt sich demnach eine Mischung aus überwachten und nicht überwachten Methoden. Aus Kostengründen wird für das Training in der Regel ein kleiner Bestand an gelabelten Daten und ein großer Bestand an ungelabelten Daten benutzt.

Reinforcement Machine Learning

Beim Reinforcement Learning, oder bestärkendem Lernen, geht es darum, die beste Strategie zu lernen. Der Algorithmus erkennt durch Versuch und Irrtum, welche Aktionen am meisten belohnt werden. Das System soll Aktionen wählen, die die größtmögliche Belohnung innerhalb eines festgelegten Zeitrahmens ergeben.

Bei diesem Modus soll also möglichst das ideale Verhalten in einem bestimmten Kontext bestimmt werden, um die gewünschte Leistung zu maximieren.

“Falsches” Lernen und toxische Sprache

Die Trainingsdaten enthalten gelegentlich toxische Sprache, und GPT-3 erzeugt gelegentlich toxische Sprache als Ergebnis der Nachahmung seiner Trainingsdaten, einschließlich Fehlinformationen, Spam, Phishing etc.

OpenAI hat diverse Maßnahmen ergriffen, um die Menge an unerwünschtem (toxischem) Content, der durch GPT-3 generiert wird, zu reduzieren.

Im Vergleich zu seinen Vorgängermodellen GPT-1 und 2 generiert GPT-3 dank dieser Maßnahmen weniger toxischen Content.

Bereits im Jahr 2021 gab OpenAI bekannt, dass genügend Sicherheitsvorkehrungen getroffen wurden, um den Zugang zu seiner API uneingeschränkt zu ermöglichen.

Welche Lernmethode setzt ChatGPT ein?

ChatGPT setzt sowohl überwachtes Lernen als auch das Reinforcement Learning ein. Bei beiden Ansätzen werden menschliche Trainer:innen eingesetzt, um die Leistung des Modells mit Hilfe von „Belohnungsmodellen“ und einem Proximal Policy Optimization-Algorithmus (PPO) zu verbessern. Darüber hinaus sammelt OpenAI weiterhin Daten von ChatGPT-Benutzer:innen, die für das weitere Training und das Finetuning verwendet werden können.

Die Benutzer:innen können etwa die Antworten, die sie von ChatGPT erhalten, hoch- oder herunterstufen; außerdem können sie ein Textfeld mit zusätzlichem Feedback ausfüllen.

ChatGPT ist so trainiert, dass es auf der Grundlage vorangegangener Token vorhersagen kann, was das nächste Token ist.

Was sind Token?

Token sind das Ergebnis eines Prozesses, der Tokenisierung genannt wird. Er besteht in der Abgrenzung und eventuellen Klassifizierung von Abschnitten einer Reihe (String) von Eingabezeichen.

In den GPT-Modellen wurde das Sprachverständnis im Rahmen der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) durch einen Prozess des generativen Pre-Trainings auf einem vielfältigen Korpus von gelabeltem und ungelabeltem Text verbessert, der aus Token besteht.

Schlusswort

Die GPT-Familie von OpenAI stellt einen bemerkenswerten Fortschritt in der Künstlichen Intelligenz und den NLG-Technologien dar. Besonders ChatGPT bietet viele Möglichkeiten zur Texterstellung und zur menschenähnlichen Kommunikation. In diesem Beitrag haben wir untersucht, wie das Sprachmodell entstanden ist und wieso es weiß, was es weiß.

In den Folgeartikeln steigen wir etwas tiefer in die Materie ein und ergründen, welche spezifischen Fähigkeiten es hat und wo es an seine Grenzen stößt. Schließlich werden wir anhand von verschiedenen Use Cases testen, ob und wann ChatGPT oder unser Textroboter besser abschneidet.

ChatGPT im Zeitalter von GPT-4- die realen Fähigkeiten eines ChatBots

Nachdem wir uns im letzten Beitrag eingehend mit der Entstehungsgeschichte und den Lernmethoden der Sprachmodelle GPT von OpenAI beschäftigt haben, werden wir uns in diesem Artikel die realen Fähigkeiten von ChatGPT ansehen. Wir verweisen allerdings jetzt schon auf einen weiteren Blogbeitrag, den wir ausschließlich GPT-4 widmen werden. Wie hilfreich ist ChatGPT bei der Erledigung verschiedener Aufgaben wie der Texterstellung, der Dialogbildung, der Zusammenfassung etc. genau?

Inhalte

- Produktionssteigerung

- Automatisierung von einfachen Aufgaben und Arbeitsabläufen

- Erschaffung von viralem Content für soziale Medien

- Content-Ideen

- Zielorientierte Artikel und Blogbeiträge

- Codierung

- Vereinfachung komplexer Konzepte

- Veralteter Trainingsdatensatz

- Forschungsphase und falsche Informationen

- Die Hybris

- Problematische Dienstleistung

- Systematische Fehler und Fehler bei der Informationsverarbeitung

Was kann ChatGPT?

Das Sprachmodell ChatGPT ist ein Untermodell von des Sprachmodells GPT-3, was soviel bedeutet, dass ChatGPT im Grunde genauso funktioniert wie GPT-3. Es basiert ebenso auf einer Transformer-Architektur und wird auf unüberwachte Weise trainiert. Ganz wie der Stammvater arbeitet ChatGPT, indem er das nächste Token in einer beliebigen Folge von Token vorhersagt.

Die Idee hinter allen GPT-Sprachmodellen und Kernpunkt der Arbeit von OpenAI in der Forschung auf dem Gebiet der Spracherzeugung ist genau folgende: Bei einem großen Datenkorpus lernt das Modell, indem es diese Daten (Text) liest, und wenn es etwas Ähnliches sieht, nimmt es vorweg, was es ausgeben muss.

Das große Sprachmodell verwendet dieses Wissen, um menschenähnlichen Text bzw. humanoide Antworten zu generieren. Was dem ChatBot auch sehr gut gelingt, zugegebenermaßen. Was ihn klar von anderen ChatBots unterscheidet, ist seine erstaunliche Fähigkeit, eine konsistente und präzise Konversation zu führen. Als GPT-3 im Jahr 2020 zum ersten Mal veröffentlicht wurde, war es in der Tat das größte existierende neuronale Netz, insbesondere was die Dichte anbelangt. Mit ChatGPT kannst du lange, tiefgehende Gespräche führen.

Wenn man den Hype weglässt, ist ChatGPT in seiner Hauptfunktion ein sehr anspruchsvoller ChatBot. Er performt viel besser als alle anderen bestehenden ChatBots. Im Gegensatz zu bisherigen Sprachmodellen sind die GPTs ab der Version GPT-2 zum ersten mal multitaskingfähig. In diesem Sinne hat ChatGPT tatsächlich die Möglichkeit, den gesamten ChatBot-Markt zu revolutionieren.

Einige Anwendungsbeispiele wurden bereits in 1. Teil dieses Ratgebers aufgeführt.

Hier sei angemerkt, dass ChatGPT besonders gut durch folgende rationale Fähigkeiten glänzt:

Er ist außerdem ein ausgezeichneter Geschichtenerzählen, weshalb er unter Anderem für folgende Aufgaben besonders einsatztauglich ist:

Produktionssteigerung

Letztlich erleichterten diese Skills die Kommunikation zwischen Mensch und Computer. Anstatt ein komplexes System von Codes und Softwarelösungen zu erlernen, kannst du ChatGPT in deinen eigenen Worten um etwas bitten oder etwas beantragen – und bekommst es umgehend. Insgesamt bietet ChatGPT einige erstaunliche Möglichkeiten in Bezug auf die Verarbeitung natürlicher Sprache (NLP = Natural Language Processing) und kann erheblich dazu beitragen, deine Produktivität zu steigern. Gehen wir darauf etwas näher ein:

Automatisierung von einfachen Aufgaben und Arbeitsabläufen

Zu den grundlegenden Anwendungen von ChatGPT zählt das Erledigen von Routineaufgaben und immer wiederkehrenden Arbeitsabläufen in deinem Arbeitsalltag. Er kann dir dabei helfen, deinen Zeitplan zu organisieren, indem er Besprechungen plant, Nachrichten beantwortet und dich an Fristen erinnert. So behältst du den Überblick über deine Aufgaben, ohne dich selbst um deine Termine oder dein volles E-Mail-Postfach kümmern zu müssen.

Dies kann deine Produktivität steigern, da du dadurch Zeit sparen kannst, die du sonst für die Erledigung dieser Aufgaben aufwenden müsstest. Du kannst ChatGPT ebenfalls darauf trainieren, verschiedene Nachrichten zu beantworten, zum Beispiel E-Mails, Kommentare in sozialen Medien oder Bewertungen.

Erschaffung von viralem Content für soziale Medien

ChatGPT kann dazu verwendet werden, um Social-Media-Beiträge und ganze Diskussionsrunden zu erstellen, die wahrscheinlich bei deinen Leser:innen sehr gut ankommen werden. Weil der ChatBot etwa mit riesigen Datenmengen von Twitter trainiert wurde, kennt er die besten Formulierungen für Tweets und sogar häufige Antworten auf verschiedene Arten von Posts. Das Programm kann nicht nur neuen Content für soziale Medien erstellen, sondern auch bestehenden Content so umschreiben, dass eine größere Reichweite erzielt wird.

Content-Ideen

ChatGPT ist ideal, um neue Content-Ideen zu generieren. Content-Creator brauchen z.B. immer wieder neue Ideen für ihre Kund:innen, um dadurch mehr Traffic und Engagement zu erhalten. In solchen Fällen müssen sie nur die Anforderungen der Kund:innen in ChatGPT eingeben, und schon führt der ChatBot ein Brainstorming für sie durch, das sich gewaschen hat.

Falls du hingegen bereits einen fertigen Blogbeitrag hast, dann hilft dir ChatGPT, einen catchy Titel zu finden. Oder bist du vielleicht sogar ein Schriftsteller und hast vielleicht schon ein paar Ideen für einen neuen Roman, aber noch keine konkrete Geschichte? ChatGPT kann dir helfen, deinen nächsten Bestseller zu schreiben.

Beispiel:

Anfrage: “Entwickle einen Plot für einen Liebesroman, in dem eine Köchin vorkommt, die immer Schluckauf hat. Alles muss sehr romantisch sein und immer während der Nacht spielen.”

Diese Anfrage beantwortet ChatGPT wie folgt:

“Die Geschichte dreht sich um Emma, eine talentierte Köchin in einem eleganten Restaurant in der Stadt. Emma hat ein kleines Geheimnis – sie hat seit ihrer Kindheit regelmäßig Schluckauf, und es passiert meistens in den unpassendsten Momenten.

Eines Nachts, während Emma im Restaurant arbeitet, tritt ein gutaussehender Gast namens Alex ein. Emma kann ihre Augen nicht von ihm lassen, aber als sie versucht, ihm seine Bestellung zu servieren, bekommt sie einen schlimmen Schluckauf, der einfach nicht aufhört. Alex, der bemerkt, dass Emma kämpft, bietet an, ihr zu helfen und hält sie sanft, bis ihr Schluckauf endlich vergeht.

Emma ist erleichtert und fühlt sich dankbar für Alex‘ Hilfe. In den folgenden Wochen besucht Alex das Restaurant regelmäßig, immer zur selben Zeit, wenn Emma arbeitet. Er sitzt an ihrem Tisch und sie unterhalten sich über Essen, Reisen und das Leben im Allgemeinen. Emma beginnt, sich in Alex zu verlieben, aber sie weiß nicht, ob er ihre Gefühle erwidert.

Eines Nachts beschließt Emma, Alex zu ihrem geheimen Lieblingsort zu führen – einem versteckten Dachgarten mit einem atemberaubenden Blick auf die Stadt. Dort teilen sie eine Flasche Wein und genießen die Aussicht. Plötzlich bekommt Emma wieder einen schlimmen Schluckauf, und diesmal ist es so schlimm, dass sie nicht atmen kann. Alex hält sie wieder und diesmal küsst er sie sanft, während er ihr hilft, sich zu beruhigen.

Nach diesem besonderen Moment weiß Emma, dass Alex ihre Gefühle erwidert. Sie verbringen den Rest der Nacht miteinander und reden über alles, was sie verpasst haben. Emma erkennt, dass sie die ganze Zeit auf der Suche nach jemandem war, der sie so akzeptieren würde, wie sie ist, und dass Alex diese Person ist.

In den folgenden Wochen verbringen Emma und Alex jede Nacht miteinander, immer an einem anderen romantischen Ort in der Stadt. Emma wird sich ihrer Liebe zu Alex sicherer und glücklicher. Eines Tages fragt Alex Emma, ob sie mit ihm in ein neues Leben starten möchte, und sie sagt ja. Gemeinsam verlassen sie die Stadt und beginnen ein neues Leben als Reiseblogger und Food-Blogger, immer auf der Suche nach dem nächsten romantischen Abenteuer und der besten Mahlzeit, die sie finden können.”

Etwas abgeschmackt vielleicht, aber im Großen und Ganzen gar nicht schlecht, oder?

Zielorientierte Artikel und Blogbeiträge

Je präziser du deine Anweisungen formulierst, desto höher ist die Wahrscheinlichkeit, dass der ChatBot einen Text erstellt, der die Leser:innen fesselt und z.B. auch Call to Actions enthält. Dank der Milliarden von Texten, die ihn trainiert haben, weiß ChatGPT, wie solche Artikel, Blogbeiträge und Berichte aussehen müssen, um gut performen zu können.

Codierung

ChatGPT ist in dieser Hinsicht wirklich revolutionär. Er kann nämlich auch als Programmierassistent eingesetzt werden. Mit seiner Hilfe können Programmierer:innen den elegantesten Weg zur Programmierung einer Applikation finden, den Code schreiben und Fehler erkennen. Profis haben bestätigt, dass ChatGPT von unschätzbarem Wert ist, wenn es um die Fehlersuche in Codes geht. Darüber hinaus kann das Programm auch komplexere Codes erstellen – wie etwa ein komplettes WordPress-Plugin.

Vereinfachung komplexer Konzepte

Fühlst du dich manchmal überfordert angesichts komplexer Konzepte, für die es keine einfachen Antworten zu geben scheint? Wenn jede Erklärung mehr Fragen aufwirft, als sie beantwortet, dann ist ChatGPT für dich da. Er erklärt komplizierte Konzepte, Prozesse und Phänomene auf eine leicht verständliche Art und Weise – und bleibt dabei auch noch charmant.

Was kann ChatGPT nicht?

Wenn du vielleicht etwas technophob bist oder dich einfach nicht so gut mit künstlicher Intelligenz auskennst – denkst du jetzt vielleicht, dass das alles zu schön klingt, um wahr zu sein. Bis zu einem gewissen Grad hast du auch recht. Auch wenn ChatGPT zweifelsohne einige erstaunliche Dinge tun kann, so hat er doch auch einige Grenzen. Wenn du diesen ChatBot benutzt, ist es wichtig, sich dieser Grenzen bewusst zu sein.

Veralteter Trainingsdatensatz

Was bedeutet das? Obwohl der Pre-Training-Datensatz mit GPT-4 aktualisiert wurde, endet die Welt für ChatGPT im Jahr 2021. Der Trainingskorpus des System hat, entgegen aller Annahmen, keinen direkten Zugang zum Internet, wie ihn etwa Google oder andere Suchmaschinen haben. Das bedeutet, dass ChatGPT auf das Jahr 2021 beschränkt ist, was die Daten betrifft, die es verwendet. Es verfügt über keine aktuellen Informationen, und alles, was es ausgibt, basiert auf den im Jahr 2021 eingespeisten Daten. Daher wird es keine zutreffenden Antworten auf Fragen geben, die neuere Informationen erfordern.

Forschungsphase und falsche Informationen

Wenn du ChatGPT benutzt, erhältst du als Erstes Informationen von OpenAI, dass sich der Chatbot noch in einer Forschungsphase befindet. Es kann vorkommen, dass dir Antworten gegeben werden, die plausibel klingen, aber falsch oder unsinnig sind. Sei dir daher immer bewusst, dass du mit einem Chatbot in der Forschungsphase interagierst, und betrachte die Antworten mit einer gewissen Vorsicht und Skepsis.

Die Hybris

Ein großes Limit von ChatGPT ist seine Hybris, denn die künstliche Intelligenz kann einfach nicht zugeben, etwas nicht zu wissen. Es ist und bleibt ein probabilistisches System und wann immer eine Lücke entsteht, versucht ChatGPT, sich vorzustellen, welches Token das nächste sein könnte. In diesen Fällen wird er das nächstmögliche Token einfügen, auch wenn es nicht korrekt ist. Dadurch gibt er falsche Informationen weiter, ohne dass er sich dessen bewusst ist. Dies nennen wir „halluzinieren“ oder „fabulieren“. Es ist deshalb auf jeden Fall ratsam, alle Antwort-Texte noch einmal händisch zu lektorieren.

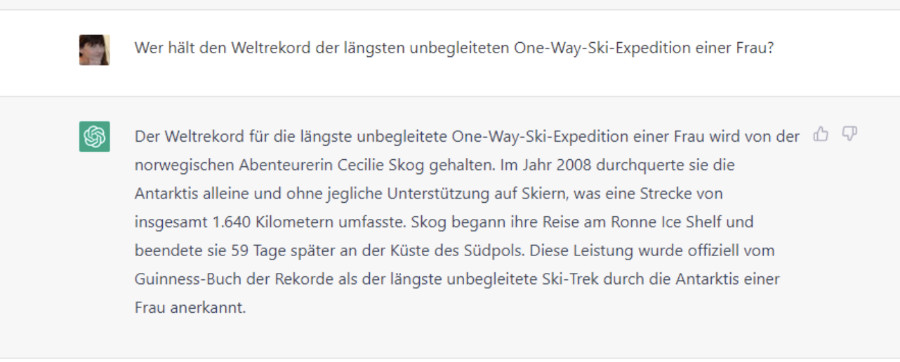

Beispiel:

Wer hält den Weltrekord der längsten unbegleiteten One-Way-Ski-Expedition einer Frau?

Die Antwort enthält viele Fehler, wenn du die Ausgabe mit der korrekten Nachricht aus der Zeitung „Rheinische Post“ vergleichst. Das bedeutet, dass du nie sicher wissen kannst, ob der Text, den du generierst, zuverlässig ist oder nicht. Besonders bei Texten für Unternehmen kann dies sehr problematisch sein.

Problematische Dienstleistung

Der Service wurde anfangs kostenlos für die Allgemeinheit zur Verfügung gestellt, mit dem Ziel, ihn zu einem späteren Zeitpunkt zu monetarisieren. Dies hat zur Folge, dass es wegen Überlastung und Übernutzung oft zu Engpässen kommt und der Service noch immer gelegentlich ausfällt. Außerdem läuft ChatGPT am besten auf Englisch, während in anderen Sprachen unterschiedliche Ergebnisse erzielt werden.

OpenAI hat jetzt allerdings für 20 US-Dollar / Monat einen Abonnementservice namens ChatGPT Plus eingeführt. Durch ihn erhalten Nutzer:innen ununterbrochenen Zugang zu ChatGPT, schnellere Antwortzeiten und früheren Zugang zu neuen Features.

Systematische Fehler und Fehler bei der Informationsverarbeitung

Es ist klar ersichtlich, dass ChatGPT oftmals unlogische Antworten auf mathematische Operationen und simple logische Rätsel liefert. Kritiker:innen haben außerdem darauf hingewiesen, dass das Programm die Vorurteile der Texte übernimmt, auf die es trainiert wurde, wenn es um das Thema Geschlecht, Rasse, Religion etc. geht. Das ist natürlich auf verzerrte Trainingsadaten zurückzuführen, die ChatGPT einfach per Mimicking übernimmt.

Obwohl unterschiedliche Filterfunktionen eingeführt wurden, ist toxische Sprache immer noch ein problematischer Aspekt des Systems.

Ethische Bedenken

ChatGPT ist sicher eine bemerkenswerte Technologie, die uns alle in ihren Bann zieht, weil es unendlich viele Möglichkeiten gibt, sie sinnvoll einzusetzen. Allerdings birgt sie auch einige Gefahren und kann durchaus auch Schaden anrichten.

Es stellt sich z.B. die Frage nach der Nachhaltigkeit, sowohl in Bezug auf den Energieverbrauch als auch auf die finanzielle Belastung. Derzeit wird geschätzt, dass der Betrieb von ChatGPT pro Tag etwa 3 Millionen USD kostet. Der Energieverbrauch und die Umweltbelastung sind ebenfalls beträchtlich, denn allein das Pre-Training von GPT-3 hinterließ ungefähr den gleichen CO2-Fußabdruck wie „die Fahrt eines Autos zum Mond und zurück“.

Das Time-Magazin enthüllte außerdem einen Missbrauchsskandal:

OpenAI setzte ausgelagerte kenianische Arbeiter:innen ein, um ein Sicherheitssystem gegen toxischen Pre-Training-Content aufzubauen und diesen zu labeln. Anhand dieser Kennzeichnungen wurde das Modell dann trainiert, um solche Inhalte in Zukunft zu erkennen und zu vermeiden. Dieser Content beinhaltete unter anderem Themen wie sexueller Missbrauch, Gewalt, Rassismus, Sexismus, Herstellung von Waffen usw. …

Das Personal, das eingesetzt wurde, erhielt eine sehr geringe Entlohnung für seine Arbeit und empfand den toxischen Inhalt, dem es ausgesetzt war, als eine regelrechte “Folter”.

Schlusswort

Obwohl ChatGPT viele neue Möglichkeiten eröffnet, ist es wichtig, die Grenzen dieser heuristischen Technologie zu erkennen und zu umgehen. ChatGPT kann z.B. nichts erledigen, was auf dem neuesten Stand sein muss. In dieser Hinsicht stellt der Textroboter ein zuverlässigeres System dar, das deterministisch-regelbasiert ist und auch mit brandneuen, spezifischen Daten gefüttert werden kann. Aus ihnen generiert der Textroboter automatisch Texte, allerdings werden diese, anders als bei ChatGPT, niemals erfunden oder falsch sein. Im Unterschied dazu empfiehlt es sich, von ChatGPT erstellte Texte immer (!) noch einmal selbst zu lektorieren.

Doch auf die einzelnen Use Cases werden wir im dritten und letzten Teil dieses holistischen Beitrages zu ChatGPT eingehen. Wir werden auch die Anwendungsmöglichkeiten des Neugeborenen GPT–4 unter die Lupe nehmen.

GPT-4 & ChatGPT vs. Textroboter: Für welche Einsatzbereiche ist welches Sprachmodell besser geeignet?

Nachdem wir in den ersten beiden Teilen dieses Ratgebers auf die Entstehungsgeschichte der diversen GPT-Modelle und deren realen Fähigkeiten eingegangen sind, wollen wir uns in diesem Teil den verschiedenen Anwendungsgebieten widmen. Du fragst dich wahrscheinlich die ganze Zeit, welcher der beiden Ansätze der richtige für dein Use Case ist: die GPT-KI oder unser Textroboter? Und inwiefern unterscheiden sich die beiden Modelle voneinander? Eben auf diese Frage gehen wir in diesem Beitrag genauer ein. Da, wie bereits erwähnt, GPT-4 vorerst nur im Bezahlmodus GPT-4 Plus und als API für Entwickler:innen zum Bauen eigener Anwendungen verfügbar ist (für den API-Zugriff besteht eine Warteliste), werden wir in diesem Beitrag bewusst noch die Anwendungsmöglichkeiten von ChatGPT erklären und diese mit denen des Textroboters vergleichen.

Inhalte

GPT-4, ChatGPT, Textroboter – Wo liegen die Unterschiede?

Alleinstellungsmerkmal: Sprachen

- Wann eignen sich GPT-Modelle und wann der Textroboter?

- Textroboter

- ChatGPT und GPT-4

- Wer sollte CHatGPT oder GPT-4 benutzen?

- Für wen eignet sich der Textroboter?

- Welche Anforderungen birgt dein Textprojekt?

- Für welche Projekte sind ChatGPT & GPT-4 sinnvoll?

- Was ist zu beachten?

Multimodalität zur Erweiterung des kreativen Schreibens

GPT-4 bzw. ChatGPT

OpenAI’s GPT-4 und ChatGPT sind beide anpassbare NLP-Modelle, die maschinelles Lernen nutzen, um natürlich klingende Antworten auf Fragen zu geben. GPT-4 ermöglicht es Benutzer:innen, eine Vielzahl von Texttypen zu generieren, während ChatGPT speziell darauf ausgerichtet ist, Konversationen zu führen.

Wie der Chatbot ChatGPT erstellt auch GPT-4 Texte, kann diese zusammenfassen, übersetzen oder vereinfachen und benutzt dazu das Verfahren des Deep Learnings. Wir werden aufzeigen, inwiefern dieses Sprachgenie dennoch nicht für alle Use Cases das richtige Tool zur Content Automation ist.

GPT-4, ChatGPT, Textroboter – Wo liegen die Unterschiede?

GPT-4, ChatGPT und unser Textroboter (Data-to-Text) sind alle Natural Language Generation (NLG)-Technologien, die es ermöglichen, Texte in natürlicher Sprache zu erzeugen. Obwohl all diese Modelle auf der gleichen Technologie fußen, unterscheiden sie sich doch in einigen Punkten wesentlich voneinander.

GPT-4 unterscheidet sich in seiner Konversationsfähigkeit nur sehr wenig vom GPT-3, welches das Modell hinter ChatGPT ist. Es handelt sich weiterhin um ein probabilistisches Sprachmodell, das anhand eines vorbestimmten Datasets vortrainiert wird.

Der Textroboter arbeitet hingegen gemäß eines deterministischen Data-to-Text-Konzepts und bezieht sich auf die automatisierte Erstellung von NLG-Texten anhand eines spezifischen, strukturierten Datensatzes.

Was sind strukturierte Daten?

Dabei handelt es sich um Attribute, die sauber in Tabellenform dargestellt werden können und wertvolle Informationen enthalten, die in die Texte einfließen können.

Beispiele hierfür sind Produktdaten aus einem PIM-System, Statistiken eines Fußballspiels oder Daten zu einer Hotel-Location.

Wenn du tiefer in das Argument “strukturierte Daten” eintauchen möchtest, dann solltest du unseren Beitrag “Holistischer Content Datenmanagement” lesen.

Nutzer:innen behalten stets die totale Kontrolle über den Output und haben die Möglichkeit, den Text jederzeit zu ändern, anzupassen oder zu aktualisieren. Du kannst also jederzeit sicherstellen, dass er den gewünschten Ton, Sprachstil und Duktus hat. Somit bleiben Konsistenz, Aussagekraft und Qualität deiner Texte einheitlich erhalten. Durch die volle Kontrolle können Texte exakt so klingen, wie du es möchtest. Zudem sind sie, im Gegensatz zu den von GPT-Modellen generierten, immer formal und inhaltlich korrekt. Sie können außerdem personalisiert und skaliert werden.

Alleinstellungsmerkmal: Sprachen

Der Textroboter generiert automatisch Texte, die auf Wunsch in bis zu 110 Sprachen ausgespielt werden können. Die Texte werden nicht nur einfach übersetzt, sondern vielmehr auf Muttersprachenniveau lokalisiert. GPT-Modelle kreieren hingegen einzelne Texte in einzelnen Sprachen. Diese müssen im Nachhinein immer noch einmal vom Menschen auf ihre Richtigkeit hin kontrolliert werden.

Skalierbarkeit

Ein weiterer fundamentaler Unterschied zwischen den beiden Tools ist die Skalierbarkeit von Texten. Werkzeuge wie unser Textroboter, die auf strukturierten Daten basieren, können in wenigen Sekunden Hunderte von Texten zu Produkten mit variablen Details erstellen. Und da jeder Text unique produziert wird, hast du für alle deine Ausgabekanäle immer genügend Content.

ChatGPT und GPT-4 können nur zur Generierung einzelner Texte verwendet werden. Dies kann zwar schnell erfolgen, jedoch haben die Nuter:innen keinen Einfluss auf die Inhalte. Mehrsprachigkeit wird bislang nur in einer begrenzten Anzahl an Sprachen unterstützt.

In welchen Use Cases eignen sich GPT-Modelle und in welchen der Textroboter zu Generierung von Texten?

GPT-Modelle sind ideal für die Ideenfindung oder als Grundlage für einen Text, z. B. einen Blogbeitrag. Data-to-Text-Software hingegen ist am besten geeignet für Unternehmen mit hohem Bedarf an Textinhalten, die viele variable Details enthalten.

Textroboter

Data-to-Text eignet sich für den Einsatz in vielen Branchen, einschließlich E-Commerce, Bankwesen, Finanzen, Pharmaindustrie, Medien und Verlagen.

Warum?

Der entscheidende Vorteil besteht darin, dass der Textroboter anhand der von den Kund:innen bereitgestellten Daten qualitativ hochwertige Beschreibungen für viele Produkte mit ähnlichen Details in verschiedenen Sprachen erzeugen kann. Dies reduziert nicht nur die Kosten und den Zeitaufwand, sondern erhöht gleichzeitig auch die SEO-Relevanz und die Konversionsraten auf den Produktseiten. Es ist fast unmöglich, manuell große Mengen an Text, wie tausende von Produktbeschreibungen für einen Online-Shop zu verfassen. Erst recht, wenn sie regelmäßig aktualisiert werden müssen, beispielsweise wegen saisonaler Einflüsse.

Hier ist der Textroboter sehr nützlich. Wenn das Projekt einmal eingerichtet ist (Set-up), müssen nur noch die Daten aktualisiert werden. Dadurch wird der vorhandene Text automatisch angepasst oder neue und unique Texte werden erstellt. Besonders für Pharma- und Finanzunternehmen ist das interessant, da sie aus den Daten oder Statistiken verschiedenste Texte wie Reportings, Analysen usw. automatisch erstellen können.

Angenehmer Nebeneffekt: Mehr Zeit für kreatives Schreiben

Die automatisierte Texterstellung schafft zeitliche Freiräume für kreative oder konzeptionelle Arbeit.

ChatGPT und GPT-4

GPT-Tools helfen hingegen beim Brainstorming und stellen auch eine formidable Inspirationsquelle dar. Wann immer es darum geht, neue, brillante Ideen zu finden, sind diese Sprachmodelle einfach perfekt. Sie arbeiten schnell, koordinieren Inputs im Handumdrehen und liefern, je nach Thema, erstaunlich gut geschriebene, fantasievolle Texte. Aus diesem Grund kann sich ihr Einsatz trotz der potenziellen Fehleranfälligkeit durchaus lohnen. Jedes Mal etwa, wenn ein langer Text anhand eines geringen Prompts (Inputs) generiert werden soll. Oder wenn es einfach keinen Menschen gibt, der schreiben kann, oder wenn es aus Kosten- oder Zeitgründen sich einfach nicht lohnt, Texte händisch zu verfassen. Ein Beispiel hierfür ist die Beantwortung von immer wiederkehrenden Kundenanfragen.

Wer sollte ChatGPT oder GPT-4 benutzen?

Diese Sprachmodelle sind immer dann sinnvoll, wenn einzelne, erfinderische Texte schnell und kostengünstig erstellt werden müssen, wie etwa beim Geschichtenerzählen. Es werden sich daher besonders Blogger:innen und Shops/Institutionen mit geringem Textbedarf angesprochen fühlen. Aber auch Marketing-Manager:innen oder Social Media Manager:innen können diese Tools profitabel einsetzen. Vor allem in Blogbeiträgen werden in der Regel häufig wechselnde Themen behandelt. Ihre geringe Anzahl rechtfertigt einfach nicht den großen Aufwand für das erste Setup beim Textroboter. GPT-Modelle eignen sich darüber hinaus für alle diejenigen, die genügend Kapazitäten für die Nachbearbeitung der Texte haben, damit Qualität und Sinnhaftigkeit stets gewährleistet bleiben.

Für wen eignet sich der Textroboter?

Er eignet sich für alle, die große Mengen an Content für dieselbe Textart benötigen. Aber auch wer seine Inhalte schnell internationalisieren will und dabei sicherstellen möchte, dass das Branding einheitlich ist, sollte lieber zum Textroboter greifen. Data-to-Text ist durch die Eingabe individueller Daten an der Nutzerrealität orientiert, was für 100 % Präzision und den absoluten Ausschluss von Falschaussagen steht. Wer in seinem Onlineshop tausende von Artikel anbietet, braucht einfach skalierbare Texte, die immer wieder neu und einwandfrei automatisch erzeugt werden können. Ein Mouse-Klick reicht, und du hast bis zu 500.000 frische Texte für deine diversen Kanäle bereit.

Das ist keine Magie. Das ist ideenreiche, regel-und mappingbasierte Programmierarbeit!

Die Option Data-to-Text eignet sich für die Generierung großer Mengen ähnlicher Inhalte mit variablen Details, die auf der Grundlage strukturierter Datensätze erzeugt werden sollen. GPT-Modelle hingegen sind dann geeignet, wenn Inhalte ohne Datenkontext erzeugt werden müssen. Um festzustellen, welches System sich für welche Branche und Anwendung eignet, ist es somit notwendig, die Bedürfnisse der jeweiligen Projekte zu berücksichtigen.

Welche Anforderungen birgt dein Textprojekt?

- Hast du viel Content und willst du es per Mouse-Klick updaten?

- Ist dir die Kontrolle über die Content-Qualität wichtig?

- Musst du Texte personalisieren, z. B. in Ansprachen?

- Benötigst du deine verschiedenen Texte gleichzeitig in diversen Sprachen?

- Dürfen deine Texte niemals falsche Aussagen oder Fehler, welcher Art auch immer, enthalten?

- Darf bei dir kein Duplicate Content erscheinen?

- Ethisch fragwürdige Statements sind bei dir ein absolutes No-Go?

- Du möchtest das Lektorat deiner Texte nicht machen müssen?

- Du wünschst in deinen Texten neue Aussagen mit erklärendem Mehrwert?

- Du möchtest Tonalität, Duktus und Stil immer einheitlich beibehalten?

- Du wünschst SEO-optimierte Texte, um den Traffic zu steigern?

Meist trifft das auf folgende Branchen und Bereiche zu:

- Große Online-Shops mit Produkt- und Kategoriebeschreibungen

- Newsletter/News Stream

- Reiseangebote & Hotelbeschreibungen

- Berichterstattung für Gesundheitswesen, Pharmazeutik, Finanzen, Rechnungswesen, Börsen

- SEO-optimierte Landing Pages

- Verlage für Wetterberichte, Horoskope, Sportberichterstattung

- Politik, Wahlergebnisse

- Immobilienbranche, Objektbeschreibungen

- Emotionale / Saisonale Texte für nahezu jede Branchen

u.v.m.

Für welche Projekte sind ChatGPT & GPT-4 sinnvoll?

- Bist du mit Storytelling beauftragt?

- Willst du Blogbeiträge schreiben?

- Brauchst du Content für deine Social Media?

- Willst du chatten oder musst du Dialoge verwalten bzw. Fragen beantworten?

- Benötigst du Website-Vorlagen?

- Musst du Tabellen ausfüllen?

- Benötigst du Codes?

- Hast du nur Fließtext als Input, aber keine Daten?

- Du hast keine strukturierten Daten?

- Du möchtest Bilder als Prompt nutzen?

- Willst du einzelne Texte schnell und kostengünstig kreieren?

- Suchst du nach Inspiration beim Schreiben?

- Du brauchst deinen Text in einer einzigen Sprache?

- Du möchtest das erste Setup vermeiden?

- Du brauchst wenig Text anhand von geringem Content-Input?

- Du willst den wahrscheinlichsten Output, der nicht unbedingt zu 100 % korrekt sein muss?

- Du willst aus Videos, Musik und Videos Content generieren

Was ist zu beachten?

Wann immer gewisse Eigenschaften in tausenden von Texten besonders hervorgehoben und betont werden sollen, solltest du besser den Textroboter in Erwägung ziehen. Das solltest du auch dann tun, wenn deine Textausgabe schnell skalierbar sein soll (beispielsweise in Form hochwertiger Produktbeschreibungen für Hunderte oder Tausende von Produkten – und auch noch in verschiedenen Sprachen).

Sofern es nicht möglich ist, einen Text von einem Menschen schreiben zu lassen und Wiederholungen in längeren Texten in Ordnung sind, solltest du hingegen ChatGPT oder GPT-4 einsetzen. Dies ist auch dann sinnvoll, wenn keine Ressourcen für das Lektorat und die Überprüfung der Fakten zur Verfügung stehen. Beachte außerdem, dass der Textroboter immer SEO-optimierte Texte generiert, während dieser Aspekt bei den GPT-Modellen eher außen vor gelassen wird.

Multimodalität zur Erweiterung des kreativen Schreibens

Zwar bleibt GPT-4 ein reines Sprachmodell, das weiterhin nur Text erstellen wird, allerdings versteht es jetzt auch Bilder, Videos und sogar Musik. Was heißt das? Das heißt, dass diese KI in multimodaler Form Text auch nach der Eingabe von Nicht-Text durch andere Supports kreieren kann. Sogar Speech-to-Text ist damit möglich, also die Verarbeitung gesprochener Sprache. Damit lassen sich Telefonate aufzeichnen, deren Inhalt nicht mehr manuell zusammengefasst und eingetippt werden muss.

Text to Videos beim Textroboter

Und was tut sich in dieser Hinsicht beim Textroboter? Recht viel, denn Kund:innen, die aus ihren Bestandsdaten per API-Aufruf tausende von Produktbeschreibungen produzieren, können über den API-Aufruf auch tausende von Produktvideos produzieren. Diese bestehen aus vielen Bildern mit Ton, Stimme und der Produktbeschreibung zusammen mit kurzen konzentrierten Bullet-Point-Beschreibungen innerhalb des Bildes.

Der Skalierungseffekt ist immens, z. B. bei der Einführung neuer Kampagnen.

Kund:innen können ihre Produkte nicht nur auf der eigenen Plattform präsentieren, sondern auch auf allen anderen Plattformen, auf denen ihre Produkte verkauft werden. Dies ist eine multimediale Lösung, die sich positiv auf das Google-Ranking auswirken kann, da alle Inhalte im Video recherchierbar und damit SEO-relevant sind.

Schlusswort

GPT-4 und ChatGPT schreiben definitiv gute, humanoide Texte – keine Frage. Allerdings ist es wichtig, dir bewusst zu machen, welche Art von Text du wünschst und wie viel Eigenarbeit du in das Ergebnis investieren möchtest. Die GPT-Modelle nutzen Daten aus dem Internet und produzieren daraus den wahrscheinlichsten Output. Da sie nicht wissen, wie die Welt funktioniert, können sie das Resultat weder verstehen noch bewerten. Bist du sicher, dass du dich mit dem vermeintlich „wahrscheinlichsten“ Output zufriedengeben kannst? Oder ist dieses Limit nicht doch etwas zu beengend?